公司动态

收养的研究解决了上下文的非凡问题:汤蒂推出

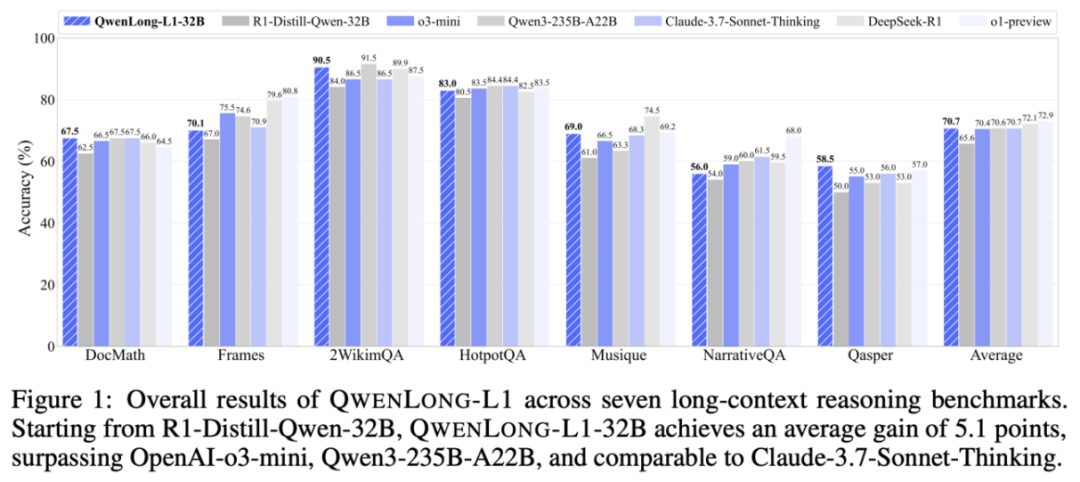

上下文的长度高达130,000个代币,适用于复杂的领域,例如多节文档综合分析,财务,法律和科学研究。最新的理解模型(LRMS)通过研究加强(RL)表现出强烈的理解,但是这些改进主要反映在理解背景的简短活动中。相比之下,如何通过研究强化来有效地处理和引起长篇小说环境仍然是一个主要挑战,但没有解决。来自阿里巴巴Talyyi实验室的团队首先是指范式研究的长篇小说推理,并认识到这两个主要挑战:次优训练效率和不稳定的优化过程。为了回应问题,团队建议Qwenlong-L1是强化研究研究的长期背景,并通过逐步扩大CON的逐步方法,通过悠久的活动逐渐改善了模型的性能文本。最后,Qwenlong-L1-32B具有许多长期基准测试基准的完美表现,不仅超过了诸如OpenOI-O3-Mini和Qwen3-235b-a22b之类的旗舰模型,而且还超过了针对Claude-3.7-3.7-Connet Thinknet Thinknint Thinkninking thinking thinking thinking的基准。基本贡献1。对上下文推理的研究研究推广的确定与短期理由的研究不同。加强的研究促进了内部知识的使用。对上下文推理的谴责研究需要该模型首先找到外部基本信息,然后包括内部推理。 2.确定对愤怒吸收的研究的关键问题。长篇文化合理的强化训练无效,如(a)链接缓慢的奖励和(b)模型的输出熵的大幅度降低,限制了优化过程中的勘探行为。同时,研究教育研究的漫长背景是不稳定的,这是非常不稳定的SED AS(c)更多的KL差异 - 各种差异,这是由于(d)较长的输出长度和不均匀的输入,导致了不稳定的方法更新。 3。Qwenlong-l1长篇小说推理增强学习框架的构建基于渐进式上下文扩展技术器和混合奖励的机制。 Qwenlong-L1通过研究增强实现从短文本到长文本的扎实环境的适应。 4。与模型概念的剪裁长上下文相比,开放的资源Qwenlong-L1-32B长上下文推理模型,Qwenlong-L1-32B取得了显着提高,与DeepSeek-R1-Disti-Disti-Disti-Disti-disti-disti-Qwen-32b相比,平均增长了7.8%。它不仅不仅仅是旗舰模型,例如OpenAI-O3-Mini和Qwen3-235b-A22b,而且还基准了Claude-3.7-Net思想思想的性能,这为长文本优化文本提供了基本的技术解决方案。基本技术基于传统的SH学习研究的环境。主要是qwenlong-l1刻画奖励机制。渐进的OneScontext扩展技术在理解具有不稳定优化属性的大型模型的漫长背景下实践。为了解决这些问题,我们提出了扩展环境的渐进概述,其中包括:对课程操作研究的研究,以稳定从短到长篇小说的优化过程;在探索复杂机会之前的贫困机制;以及一个牢固管理的微调预热阶段,为在强化研究培训之前开始提供了良好的基础。强烈地管理精细的加热安排:使用蒸馏的长篇小说的数据前景,以促进良好的模型调整,以便在研究加固以获取稳定的初始技术并减少训练过程中的不稳定性。研究课程倡导:加强研究培训分为两个阶段,INPUT阶段的长度为20K,并将II期扩展到60k,逐渐适应了长篇小说。在每个阶段只训练当前长度间隔的示例,以防止由混合物引起的优化 - 长度长度。回顾性的感知贫困:基于样本平均奖励动态贫困计算,奖励示例低(高难度)在后续阶段保留。在第二阶段训练期间,包含I期的高难度样本迫使我继续探索复杂的病例。奖励的混合机制在开始结构的开始,例如数学,编程和逻辑推理,以前的研究工作通常使用基于奖励的功能。但是,开放式域问答和其他上下文连词任务揭示了独特的挑战,因为它们的自然差异不同。在这种情况下,基于奖励的奖励机制可能会限制有效答案的变化,可能会影响整体性能。从这些限制来看,我们建议一种混音-A奖励机制,其中包括对模型规则和评估的验证,并通过评估完成之间的准确性和纪念之间达到平衡。规则奖励:I-通过正则表达式从模型输出中提取答案,并严格删除通常的答案。确保正确的答案格式并避免入侵奖励。模型分析:培训过程使用QWEN2.5-1.5B-Instructura作为轻量级判断模型,以评估预测答案和通常答案之间的语义平等。结合策略:考虑到差异的准确性和答案,最终奖励是模型规则和判断的最高价值。该实验发现,与SFT相比,RL性能得到了显着改善:在R1-Distill-QWEN模型之后,仅需要1.6K高质量的样本来改善RL,而14B型号的平均增加了4.132B型号的平均增加为5.1。国内外领先的旗舰侵权模型:Qwenlong-L1-14b平均通行证@1达到68.3,超过了Gemini-7.0-Flash-thinking,R1-Distill-Qwen-32b,Qwen3-32b; QWENLONG-L1-32B模型平均通过@1达到70.7,超过QWQ-Plus,Qwen3-plus,OpenAi-O3-Mini,与Claude-3.7-Connet-Connet-Inkining相同;测试时间缩放具有明显的性能:Qwenlong-L1-14b型号平均通行@2达到73.7,超过了DeepSeek-R1(Pass@1,72.1),OpenAI-O1-Preview(Pass@1,72.9)。 SFT和RL在探索不同模型的起点RL:基本模型,短篇小写SFT模型(= 20K),长篇小写SFT模型(= 60K)之后的取舍。有趣的 - 友好的发现:SFT和RL扮演辅助角色,SFT的成本较低 - 可接受的性能,RL对于取得最佳结果至关重要;为了实现最佳性能,应将RL优先考虑SFT,因为过度关注to sft可能会导致您的最佳选择,从而限制RL的改进;在训练过程中,动态变化的行为的出现和不断变化的情境行为:包括与预防,验证,子目标环境以及与推理有关的相关有关的评估和一般预防措施相关的延长背景和一般预防措施。有趣的发现:所有模型都显示出不同的理解模式,并且与上下文相关的上下文的频率最高。 RL自然会导致这些模式出现更频繁的频率,最终的性能也将相应地提高。 SFT尽管理解模式上升高于RL,但将转换性能改进与RL进行了比较。我有限的这项研究通过研究强化探索了长期识别模型的发展。它首先提出了为长期推理加强研究的范式并发现了关键问题,例如次优培训效率和不稳定的优化过程。为了应对这些挑战,研究团队启动了Qwenlong-L1,这是一种扩大加强研究框架的增量环境。实验结果表明,Qwenlong-L1在领导模型上下文模型的行业中表现良好。其中,Qwenlong-L1-14B的性能超过了GEMINI-2.0-FLASH思想和QWEN3-32B,而Qwenlong-L1-32B超过了OpenAi-O3-Mini,Qwen3-235b-a22b,甚至与Claude-3.7-Connet-clane-3.7-connet-inging-inging-inging-inging。我们的审查对长期研究的三个主要观点发表了三种主要观点:扩展背景在实现稳定适应方面的重要作用,优先级的优先级刺激了学习优化绩效的需求,以及在教育教育中提高培训中长期推理文本的作用,以促进绩效提高。

上下文的长度高达130,000个代币,适用于复杂的领域,例如多节文档综合分析,财务,法律和科学研究。最新的理解模型(LRMS)通过研究加强(RL)表现出强烈的理解,但是这些改进主要反映在理解背景的简短活动中。相比之下,如何通过研究强化来有效地处理和引起长篇小说环境仍然是一个主要挑战,但没有解决。来自阿里巴巴Talyyi实验室的团队首先是指范式研究的长篇小说推理,并认识到这两个主要挑战:次优训练效率和不稳定的优化过程。为了回应问题,团队建议Qwenlong-L1是强化研究研究的长期背景,并通过逐步扩大CON的逐步方法,通过悠久的活动逐渐改善了模型的性能文本。最后,Qwenlong-L1-32B具有许多长期基准测试基准的完美表现,不仅超过了诸如OpenOI-O3-Mini和Qwen3-235b-a22b之类的旗舰模型,而且还超过了针对Claude-3.7-3.7-Connet Thinknet Thinknint Thinkninking thinking thinking thinking的基准。基本贡献1。对上下文推理的研究研究推广的确定与短期理由的研究不同。加强的研究促进了内部知识的使用。对上下文推理的谴责研究需要该模型首先找到外部基本信息,然后包括内部推理。 2.确定对愤怒吸收的研究的关键问题。长篇文化合理的强化训练无效,如(a)链接缓慢的奖励和(b)模型的输出熵的大幅度降低,限制了优化过程中的勘探行为。同时,研究教育研究的漫长背景是不稳定的,这是非常不稳定的SED AS(c)更多的KL差异 - 各种差异,这是由于(d)较长的输出长度和不均匀的输入,导致了不稳定的方法更新。 3。Qwenlong-l1长篇小说推理增强学习框架的构建基于渐进式上下文扩展技术器和混合奖励的机制。 Qwenlong-L1通过研究增强实现从短文本到长文本的扎实环境的适应。 4。与模型概念的剪裁长上下文相比,开放的资源Qwenlong-L1-32B长上下文推理模型,Qwenlong-L1-32B取得了显着提高,与DeepSeek-R1-Disti-Disti-Disti-Disti-disti-disti-Qwen-32b相比,平均增长了7.8%。它不仅不仅仅是旗舰模型,例如OpenAI-O3-Mini和Qwen3-235b-A22b,而且还基准了Claude-3.7-Net思想思想的性能,这为长文本优化文本提供了基本的技术解决方案。基本技术基于传统的SH学习研究的环境。主要是qwenlong-l1刻画奖励机制。渐进的OneScontext扩展技术在理解具有不稳定优化属性的大型模型的漫长背景下实践。为了解决这些问题,我们提出了扩展环境的渐进概述,其中包括:对课程操作研究的研究,以稳定从短到长篇小说的优化过程;在探索复杂机会之前的贫困机制;以及一个牢固管理的微调预热阶段,为在强化研究培训之前开始提供了良好的基础。强烈地管理精细的加热安排:使用蒸馏的长篇小说的数据前景,以促进良好的模型调整,以便在研究加固以获取稳定的初始技术并减少训练过程中的不稳定性。研究课程倡导:加强研究培训分为两个阶段,INPUT阶段的长度为20K,并将II期扩展到60k,逐渐适应了长篇小说。在每个阶段只训练当前长度间隔的示例,以防止由混合物引起的优化 - 长度长度。回顾性的感知贫困:基于样本平均奖励动态贫困计算,奖励示例低(高难度)在后续阶段保留。在第二阶段训练期间,包含I期的高难度样本迫使我继续探索复杂的病例。奖励的混合机制在开始结构的开始,例如数学,编程和逻辑推理,以前的研究工作通常使用基于奖励的功能。但是,开放式域问答和其他上下文连词任务揭示了独特的挑战,因为它们的自然差异不同。在这种情况下,基于奖励的奖励机制可能会限制有效答案的变化,可能会影响整体性能。从这些限制来看,我们建议一种混音-A奖励机制,其中包括对模型规则和评估的验证,并通过评估完成之间的准确性和纪念之间达到平衡。规则奖励:I-通过正则表达式从模型输出中提取答案,并严格删除通常的答案。确保正确的答案格式并避免入侵奖励。模型分析:培训过程使用QWEN2.5-1.5B-Instructura作为轻量级判断模型,以评估预测答案和通常答案之间的语义平等。结合策略:考虑到差异的准确性和答案,最终奖励是模型规则和判断的最高价值。该实验发现,与SFT相比,RL性能得到了显着改善:在R1-Distill-QWEN模型之后,仅需要1.6K高质量的样本来改善RL,而14B型号的平均增加了4.132B型号的平均增加为5.1。国内外领先的旗舰侵权模型:Qwenlong-L1-14b平均通行证@1达到68.3,超过了Gemini-7.0-Flash-thinking,R1-Distill-Qwen-32b,Qwen3-32b; QWENLONG-L1-32B模型平均通过@1达到70.7,超过QWQ-Plus,Qwen3-plus,OpenAi-O3-Mini,与Claude-3.7-Connet-Connet-Inkining相同;测试时间缩放具有明显的性能:Qwenlong-L1-14b型号平均通行@2达到73.7,超过了DeepSeek-R1(Pass@1,72.1),OpenAI-O1-Preview(Pass@1,72.9)。 SFT和RL在探索不同模型的起点RL:基本模型,短篇小写SFT模型(= 20K),长篇小写SFT模型(= 60K)之后的取舍。有趣的 - 友好的发现:SFT和RL扮演辅助角色,SFT的成本较低 - 可接受的性能,RL对于取得最佳结果至关重要;为了实现最佳性能,应将RL优先考虑SFT,因为过度关注to sft可能会导致您的最佳选择,从而限制RL的改进;在训练过程中,动态变化的行为的出现和不断变化的情境行为:包括与预防,验证,子目标环境以及与推理有关的相关有关的评估和一般预防措施相关的延长背景和一般预防措施。有趣的发现:所有模型都显示出不同的理解模式,并且与上下文相关的上下文的频率最高。 RL自然会导致这些模式出现更频繁的频率,最终的性能也将相应地提高。 SFT尽管理解模式上升高于RL,但将转换性能改进与RL进行了比较。我有限的这项研究通过研究强化探索了长期识别模型的发展。它首先提出了为长期推理加强研究的范式并发现了关键问题,例如次优培训效率和不稳定的优化过程。为了应对这些挑战,研究团队启动了Qwenlong-L1,这是一种扩大加强研究框架的增量环境。实验结果表明,Qwenlong-L1在领导模型上下文模型的行业中表现良好。其中,Qwenlong-L1-14B的性能超过了GEMINI-2.0-FLASH思想和QWEN3-32B,而Qwenlong-L1-32B超过了OpenAi-O3-Mini,Qwen3-235b-a22b,甚至与Claude-3.7-Connet-clane-3.7-connet-inging-inging-inging-inging。我们的审查对长期研究的三个主要观点发表了三种主要观点:扩展背景在实现稳定适应方面的重要作用,优先级的优先级刺激了学习优化绩效的需求,以及在教育教育中提高培训中长期推理文本的作用,以促进绩效提高。 上一篇:FAW Pentium Yueyi 07电动混合动力SUV在市场上,有限的 下一篇:没有了